Der Artikel befasst sich mit Forschungsarbeit eines Researcher Teams der „School of Computer Science University of Nottingham, UK“. Ziel des Projekts war es „Live-Performance Interaktionen“ mit neuen Technologien zu ergänzen, um daraus neue narrative Gestaltungsmethoden und visionäre Interfaces zu entwickeln.

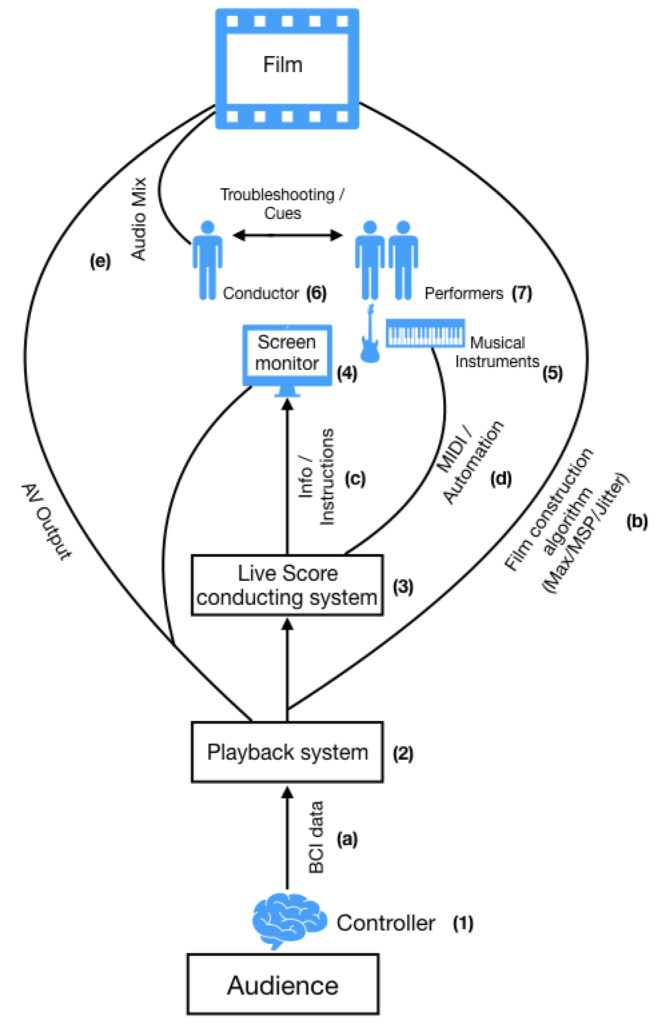

Hierbei setzte das Team auf die Entwicklung eines Systems, das es ermöglicht, mittels dem Auslesens von Gehirnwellen einen interaktiven Film zu kontrollieren. Durch die aufgezeichneten Daten werden sowohl der Handlungsstrang als auch das Audio direkt beeinflusst .

Das Ergebnis dieser Forschung ist ein interaktiver „dystopischer Science-Fiction Thriller“ mit dem Titel „The Moment“, welcher auf verschiedenen Festivals präsentiert wurde. Das Team hat es sich zum Ziel gesetzt, ihre Erkenntnisse aus diesem Projekt weiterzuentwickeln, um unter anderem die Skalierbarkeit neuer Gestaltungsformen zu untersuchen.

Die technische Umsetzung geschieht mittels einer Elektroenzephalografie (E.E.G). Ein E.G.G ist eine Methode der neurologischen Forschung zur Messung der summierten elektrischen Aktivität des Gehirns durch Aufzeichnung der Spannungsschwankungen an der Kopfoberfläche.

Als Interface wird hierzu ein E.E.G. Headset von NeuroSky benutzt, das einem der Zuseher aufgesetzt wird. Mithilfe dieses Controllers beeinflusst dieser Zuseher, direkt und in Echtzeit, sowohl den Verlauf als auch die musikalische Untermalung des Filmes. Die Zusammensetzung der musikalischen Untermalung besteht aus unterschiedlichen Parts, die live eingespeist werden. Zum einen besteht dieses Footage also aus musikalischen Arrangements und Improvisationen echter Musiker, zum anderen aus einer Collection an Audioaufnahmen, die von einem automatisierten und generative System ausgewählt und abgespielt werden.

Die Echtzeitverarbeitung des Audios geschieht mit der Software Max.

Den Entwicklern geht es nicht darum Hirnwellen zu visualisieren, sondern darum, die Stimmung des Probanden zu erfassen und den audiovisuellen Output seiner Empfindungen abzubilden. Durch die direkte Beeinflussung des Zusehers ist es möglich bis zu 17 Millionen unterschiedlicher Variationen an Shots Musik und Sounds zu kreieren.

Ich habe den Artikel gewählt, weil ich das Projekt und Forschungsgebiet sehr spannend finde und selbst im Theater-, Film- und Veranstaltungs- Bereich tätig war.

Dabei habe ich mich viel mit der Interaktion zwischen Publikum und Darstellern befasst. Die direkte Teilnahme von Publikum an Performance ermöglicht variable Outcomes, anstatt eines strengen linearen Handlungsverlaufs. Geschieht diese Beeinflussung mittels experimenteller Technik, fasziniert mich das umso mehr.

Das Brain Computer Interface (B.C.I) ist für mich ein besonders reizvolles Mittel, weil ich das „Medium“ Gehirn als eines der spannendsten Forschungsgebieten empfinde. Einerseits können mithilfe eines BCI verborgene und unbewusste menschliche Aktivitäten sichtbar gemacht werden, andererseits ist es auch möglich, wenn gleich auch nur mit genügend mentaler Kontrolle, direkte Kontrolle über das Interface zu erhalten und dieses zu steuern.

Allerdings kann ich durch eigene Erfahrung sagen, dass die „Consumer B.C.I“ Lücken aufweisen. Ihre Funktionen sind beschränkt und die Anzahl der benutzen Sensoren begrenzt. Die Hirnwellen, die gemessen werden können, sind zu ungenau, um eine akkurate Beeinflussung zu ermöglichen. Es wird weitere Entwicklungsschritte und Forschungen geben müssen, um B.C.I.‘s zu alltagstauglichen Interfaces zu entwickeln. Es gibt bereits jetzt VR Brillen, die sich mittels Hirnwellen steuern lassen. In China existieren Versuchsklassen in Schulen, wenngleich auch kritisiert und teilweise bereits gestoppt, in denen die Aufmerksamkeit der Schüler mittels B.C.I. gemessen und analysiert wird.

Und endlose Projekte mehr. Es wird sich also in Zukunft sicherlich noch einiges tun in diesem Bereich.

Quellen:

https://www.nime.org/proceedings/2019/nime2019_paper007.pdf